El laboratorio del profesor Yoshua Bengio, premio Turing 2018, desarrolla una herramienta con potentes algoritmos que simula los efectos de inundaciones y otros fenómenos meteorológicos extremos en cualquier lugar del mundo

La mayoría de consecuencias físicas derivadas del calentamiento global nos quedan lejos. Y al no sufrirlas directamente, nos cuesta interiorizar la extrema gravedad de la crisis climática que atraviesa el planeta. El Quevec AI Institute (MILA) ha querido poner su granito de arena para concienciar a la población sobre el mundo hacia el que vamos. Un equipo de investigadores del prestigioso centro que dirige Yoshua Bengio, considerado uno de los padres de las redes neuronales, ha desarrollado una herramienta que permite visualizar los efectos de inundaciones, incendios o nubes de polución en cualquier lugar del mundo. La simulación corre a cargo de una red generativa antagónica (GAN), un tipo de algoritmo de aprendizaje automático (machine learning) que se usa, por ejemplo, para generar de la nada imágenes realistas, como las de los rostros de personas inexistentes de thispersondoesnotexist.com o las de los vídeos deep fake.

El proyecto, en el que ha trabajado una treintena de científicos durante dos años, tiene de hecho un nombre inspirado en la icónica web de personas falsas: This Climate Does Not Exist (Este clima no Existe). Abierta al público desde este jueves, lo único que tiene que hacer el usuario es teclear una dirección o seleccionar un punto recogido por Google Street View. A continuación, se debe indicar qué tipo de catástrofe quiere ver: inundación, incendio incontrolado o nube de polución. El algoritmo hace su magia y devuelve la imagen con el efecto solicitado.

El realismo es particularmente llamativo en la opción de inundación, la que más quebraderos de cabeza le ha llevado al equipo de Bengio. El algoritmo toma la imagen propuesta por el usuario, le coloca automáticamente una capa de agua y después la pinta con los reflejos del entorno de la propia imagen. El resultado es hiperrealista.

“Uno de los retos más importantes ha sido conseguir que el algoritmo sea capaz de simular inundaciones en una gran variedad de imágenes”, explica Alex Hernandez-Garcia, uno de los investigadores principales del proyecto. “Simplificándolo mucho, un módulo del algoritmo se encarga de detectar qué partes de la imagen deben cubrirse con agua y otro módulo se encarga de generar la textura del agua incorporando el contexto de la imagen, por ejemplo el reflejo de los edificios. Finalmente, el resultado de estos dos módulos se combina para generar la imagen final”.

Para detectar dónde cubrir con agua y dónde no, Hernandez-Garcia y sus colegas combinaron varias técnicas de visión artificial y aprendizaje automático. “Por un lado, generamos una ciudad virtual por ordenador que nos permitió tener una serie de imágenes con y sin agua. También ajustamos un algoritmo que fuera capaz de hacer buenas predicciones en ese mundo virtual, detectando las distintas partes de una escena: suelo, coches, edificios, árboles, gente, etcétera”, ilustra. “Por otro lado, el algoritmo debe ser capaz de hacer buenas predicciones en imágenes reales (las de Google Street View)”. Para esto último usaron las redes generativas antagónicas (GAN).

El proceso se completa en escasos segundos y, antes de mostrárselo al usuario, se le aporta información sobre las causas y consecuencias del fenómeno meteorológico seleccionado y su relación con el cambio climático. Por ejemplo, si se opta por una inundación, se indica que las inundaciones repentinas matan a unas 5.000 personas al año, que se espera que el nivel del mar suba dos metros para finales de siglo y que esa importante alteración del planeta alterará para siempre la vida de al menos 1.000 millones de personas para finales de 2050. “Si no hacemos nada pronto afrontaremos grandes catástrofes climáticas”, señala el profesor Bengio, director científico de MILA. “Esta web hace que los riesgos del cambio climático sean mucho más reales y personales para la gente”, sostiene.

Redes generativas antagónicas

La inteligencia artificial dio un salto de calidad hace en torno a una década con el surgimiento y consolidación del aprendizaje automático y el aprendizaje profundo (deep learning). Estas técnicas se basan en entrenar a la máquina para que, tras llegar por sí misma a ciertas conclusiones, sea capaz de realizar tareas complejas. Por ejemplo, si se desea que el algoritmo distinga entre madalenas o chihuahuas, el programador aporta una serie de ejemplos de cada categoría y luego le entrega miles de imágenes sin clasificar. La máquina establecerá sus asociaciones y, cuando se equivoque y se le haga notar el error, refinará sus criterios de distinción.

Bengio ganó en 2018 el Premio Turing, considerado el Nobel de la informática, junto a Geoffrey Hinton y Yann LeCun por su aportación al desarrollo de las redes neuronales. Son un paso más en el aprendizaje automático e intentan imitar el funcionamiento del cerebro humano: aplican varias capas simultáneas de procesamiento, lo que aumenta su rendimiento. Están detrás de los sistemas de clasificación más complejos, como los asistentes de voz o los modelos de predicción avanzados.

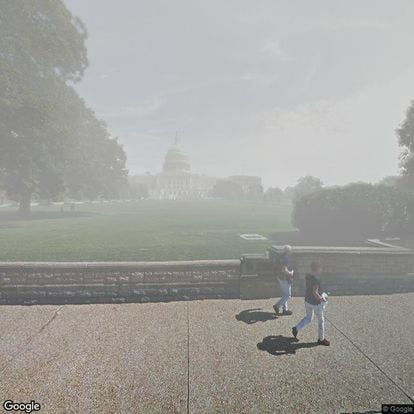

Las redes generativas antagónicas (del inglés generative adversarial networks, GAN) van todavía un poco más allá. Se inventaron también en el MILA en 2014 y son capaces de generar contenido nuevo que, a ojos humanos, parece totalmente real. Están detrás de los cada vez más sofisticados vídeos falsos hiperrealistas (deep fake) generados por ordenador en los que personajes conocidos pueden decir o hacer lo que uno quiera. Funcionan gracias a la competición entre dos redes neuronales: una de ellas trata de elaborar imágenes lo más realistas posibles y la otra intenta detectar si son reales o una invención. Eso sucede miles o millones de veces y, durante el proceso, la red generadora aprende a crear imágenes cada vez más logradas. Cuando la primera logra engañar a la segunda tenemos la imagen ganadora. Por ejemplo, la de la Plaza de Cibeles inundada o el Capitolio sumido en una nube tóxica.

“Estamos usando un nuevo tipo de GAN desarrollado por nosotros mismos para generar las imágenes de cambio climático que se pueden ver en nuestra web”, explican desde MILA. “En general, la disponibilidad limitada de imágenes y la necesidad de adaptar el algoritmo a multitud de situaciones han sido los retos técnicos principales a los que nos hemos enfrentado”, sostiene Hernandez-Garcia.